首先来安装运行环境。我们需要安装“Ollama”软件,它就像是AI模型的运行容器。

步骤如下:

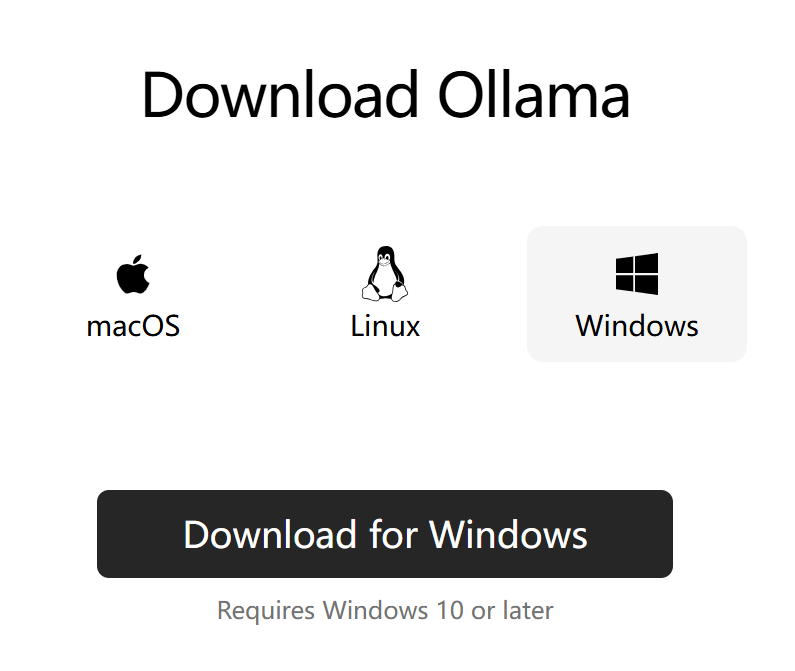

1. 打开浏览器访问欧拉玛官网:https://ollama.com/

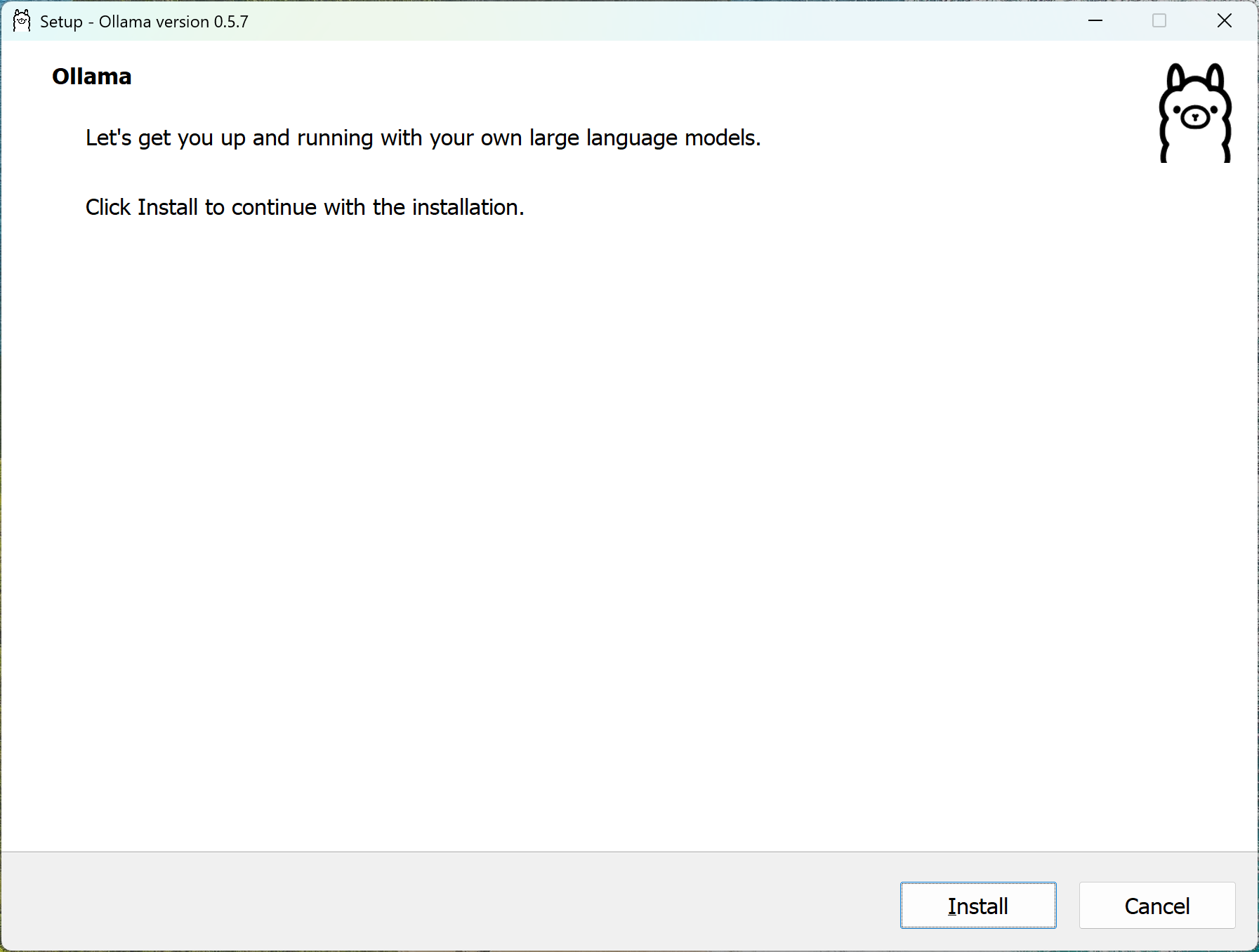

2. 根据系统选择对应版本:

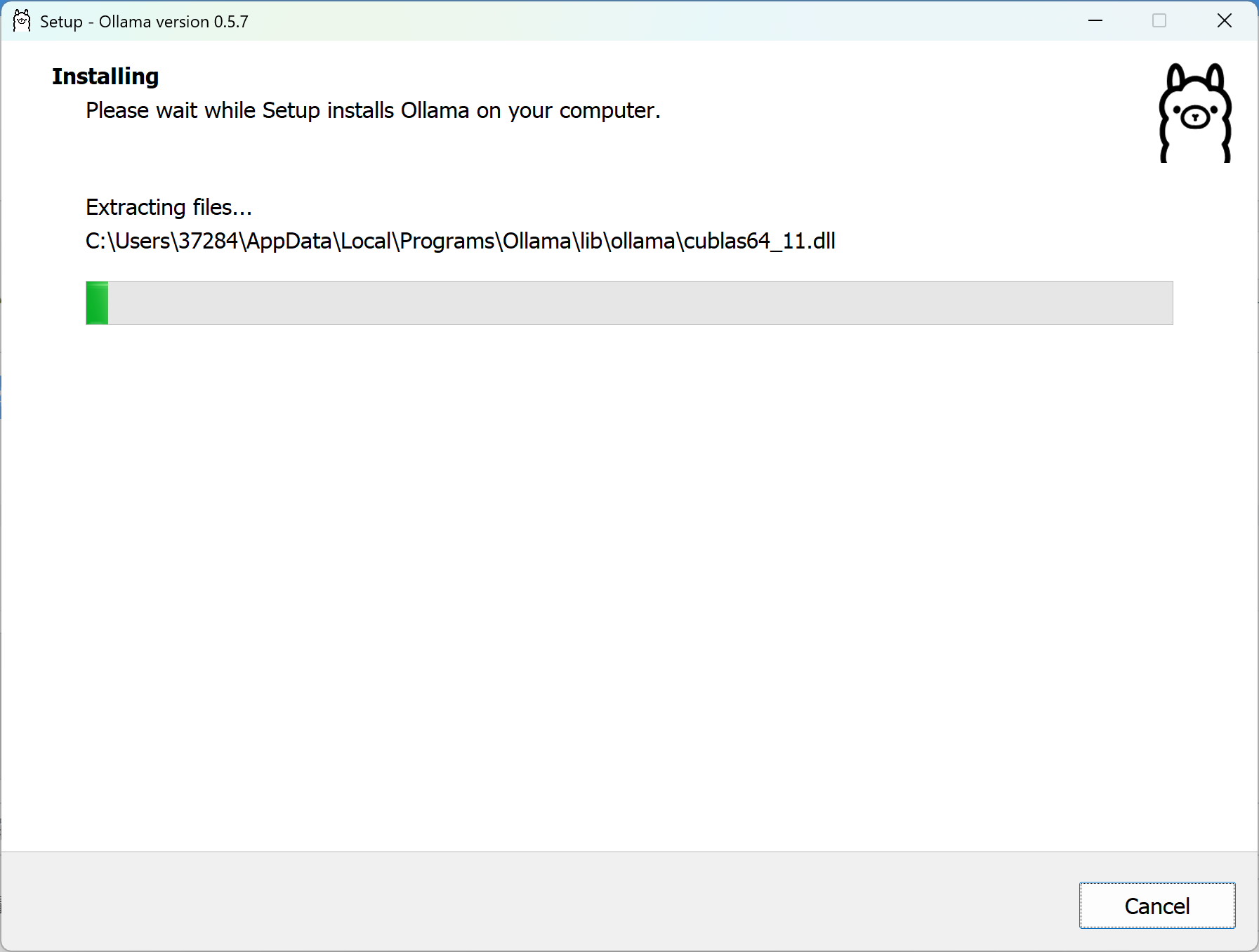

3. 下载并完成安装

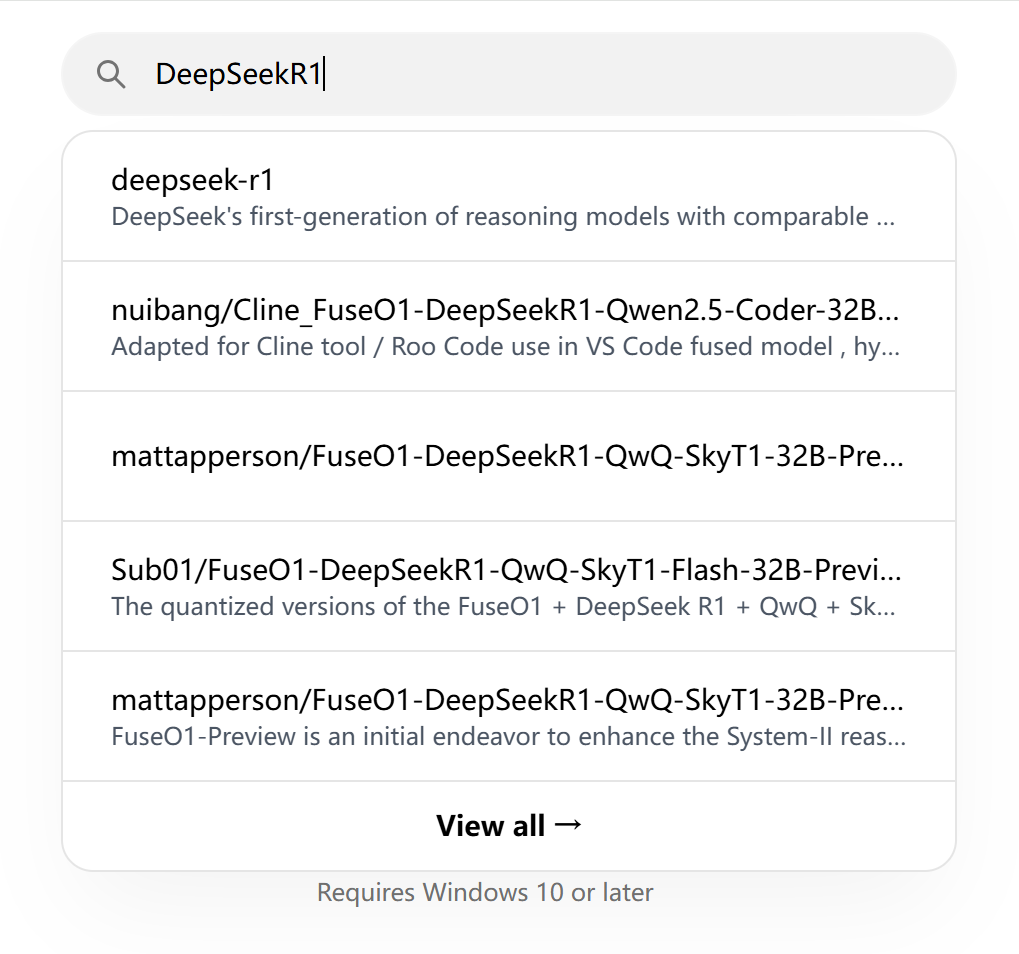

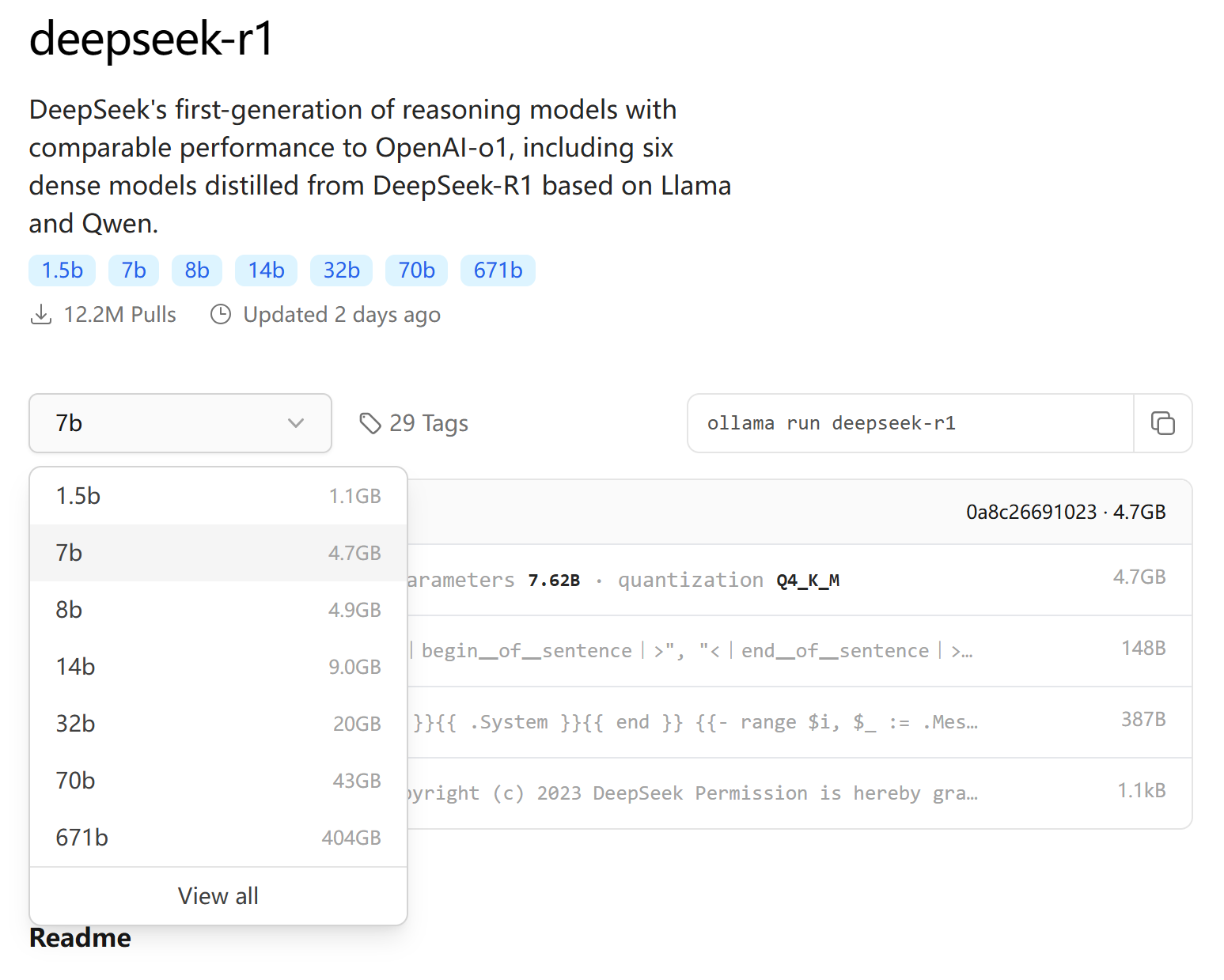

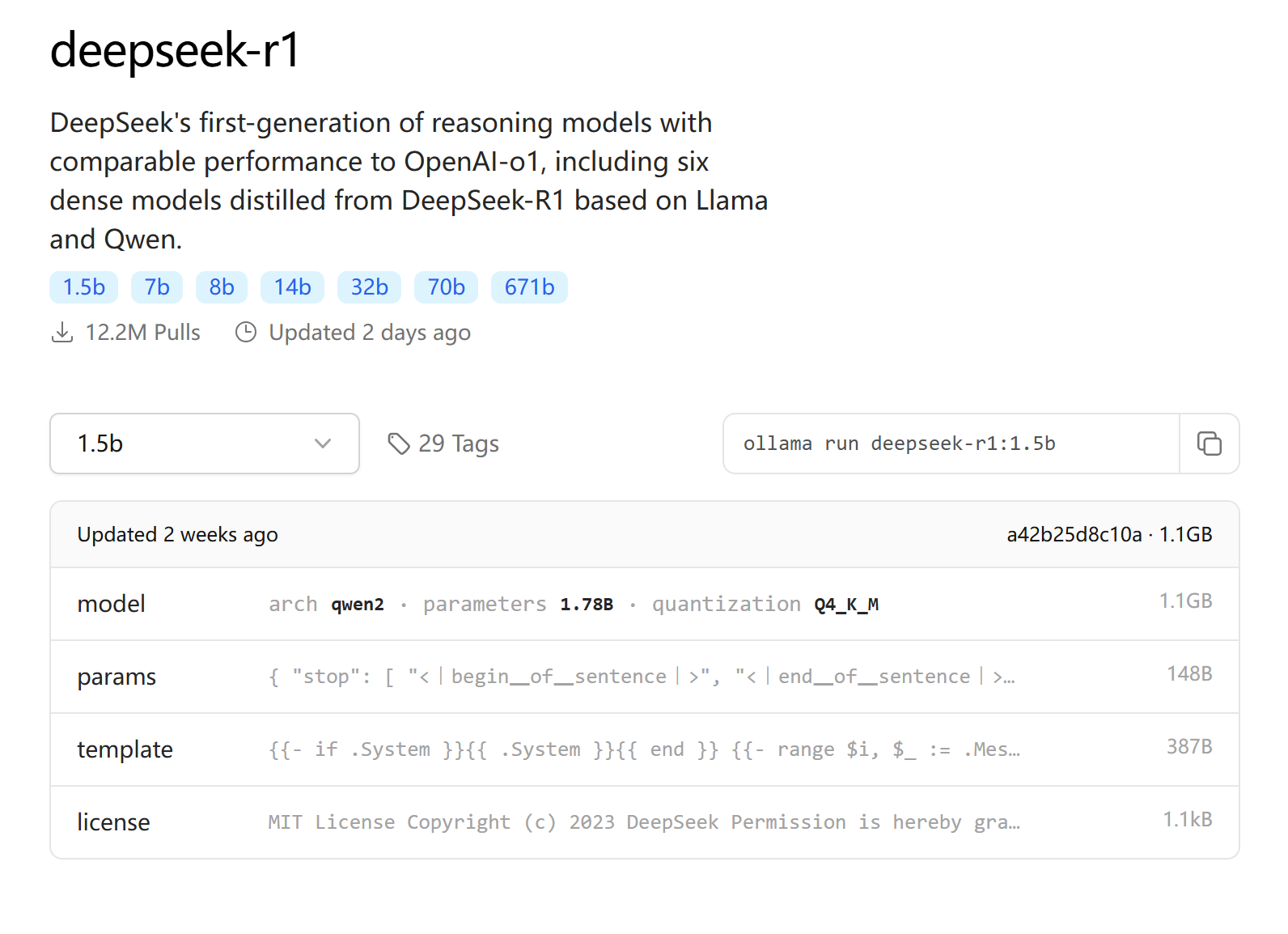

接下来是模型选择环节。在ollama官网搜索DeepSeekR1,你会看到不同参数规模的版本。

参数量越大,模型能力越强,但对设备要求也越高。建议新手可以先尝试1.5B版本(15亿参数),足以应付日常使用了。找到合适的版本后,复制旁边的安装命令。

提示:对于初学者来说,从较小的模型开始是明智之选。

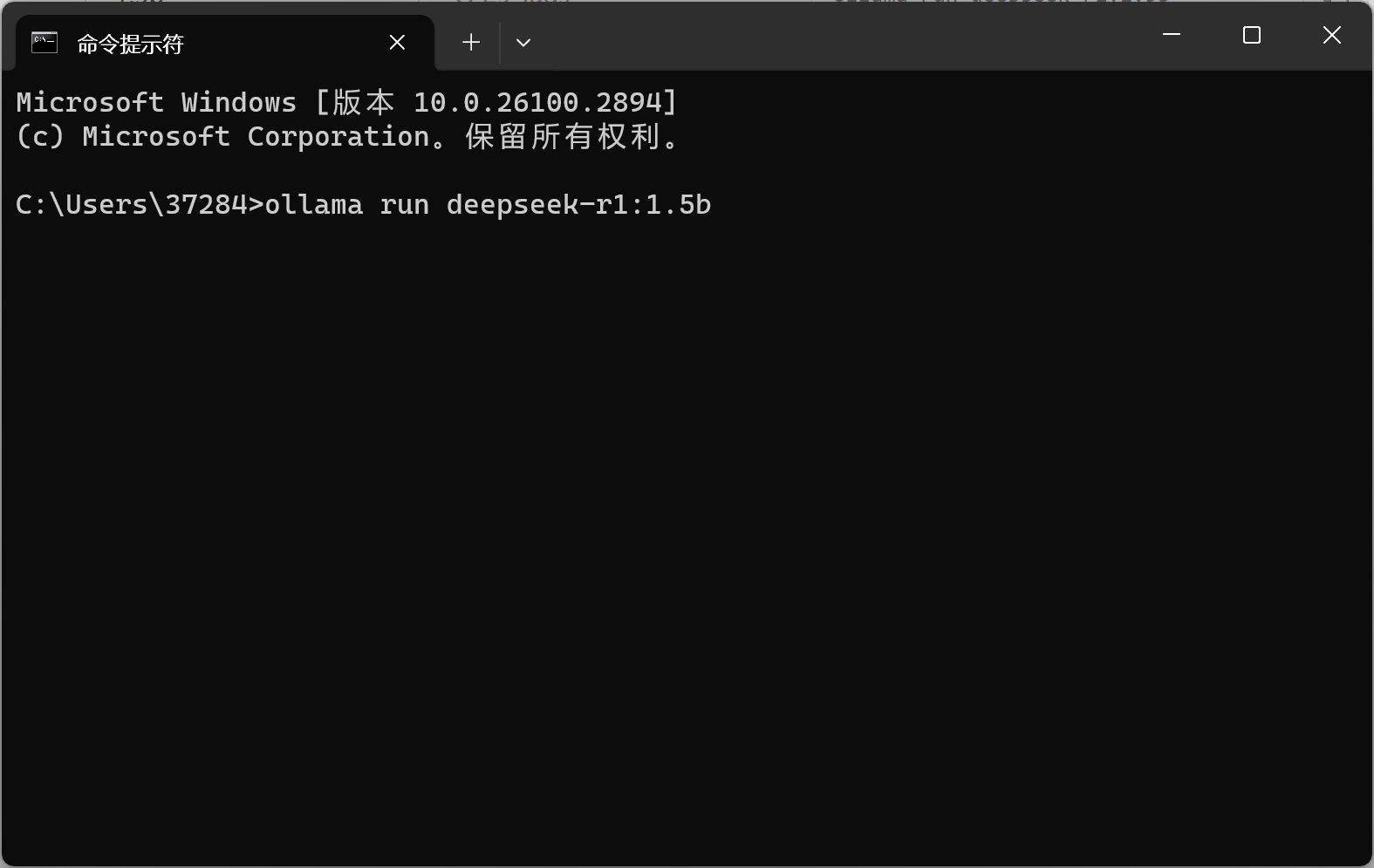

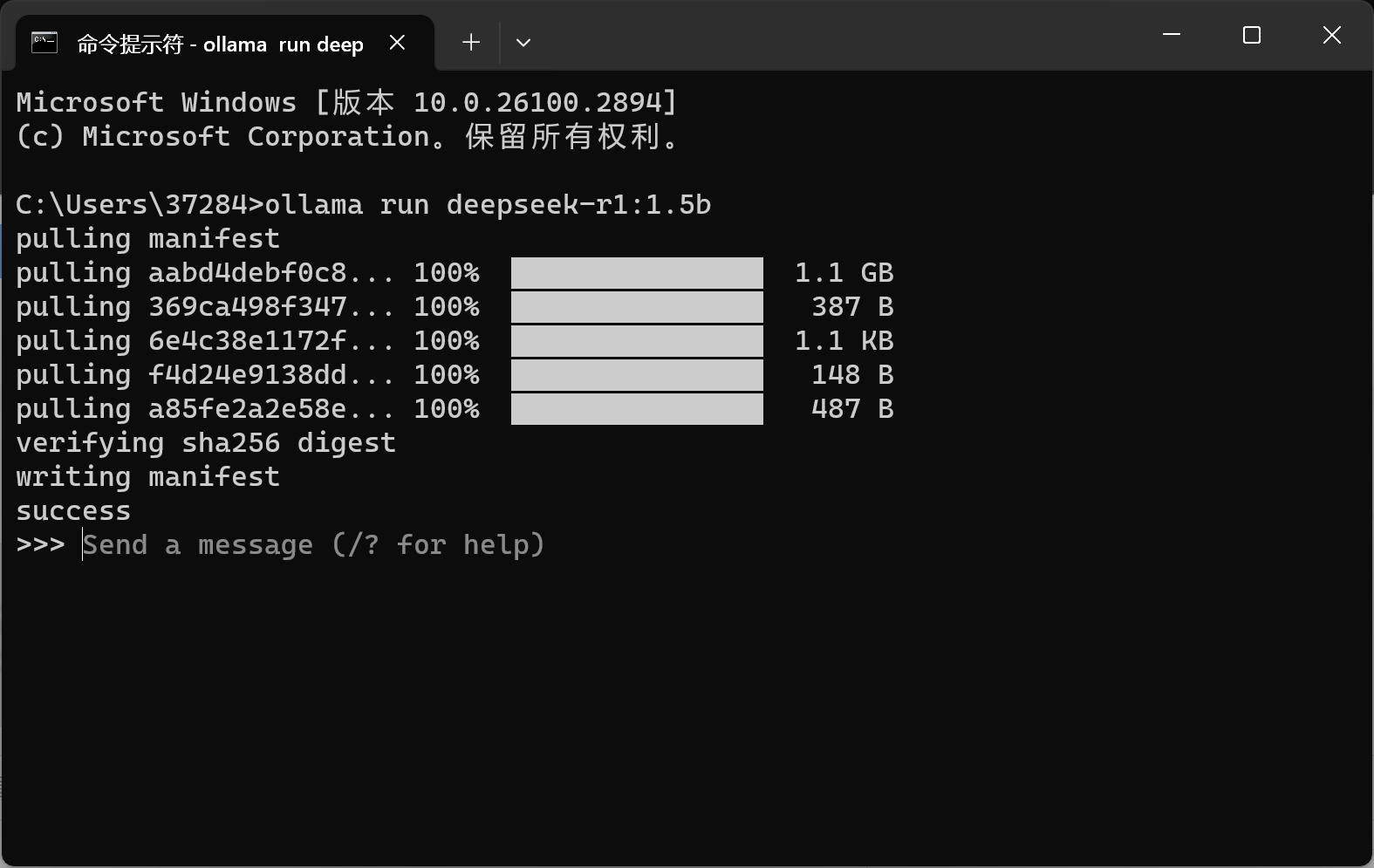

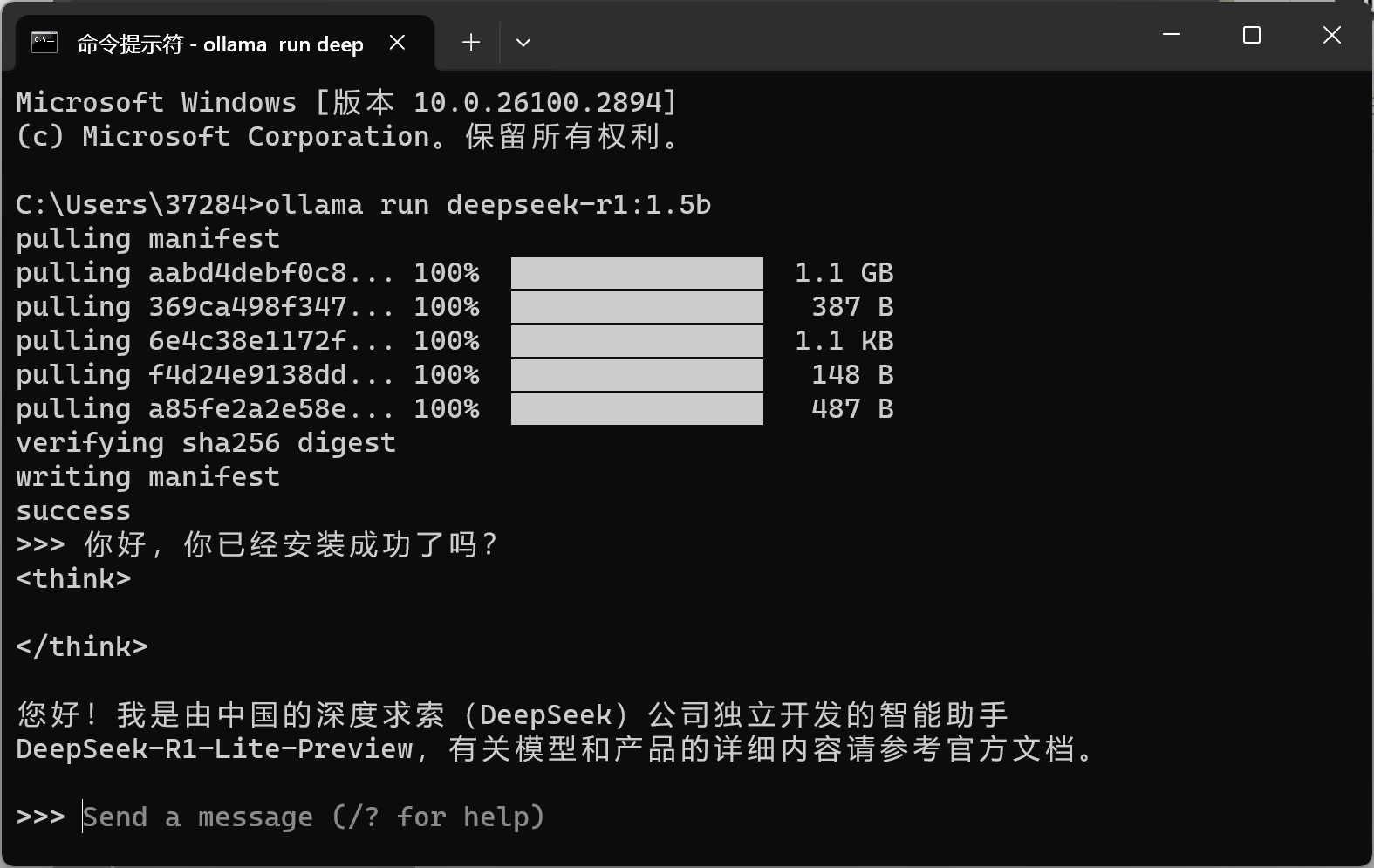

最后一步是模型安装。只需打开命令行窗口,粘贴刚才复制的命令,系统就会自动开始下载模型。安装完成后就可以开始对话了,响应速度相当不错!

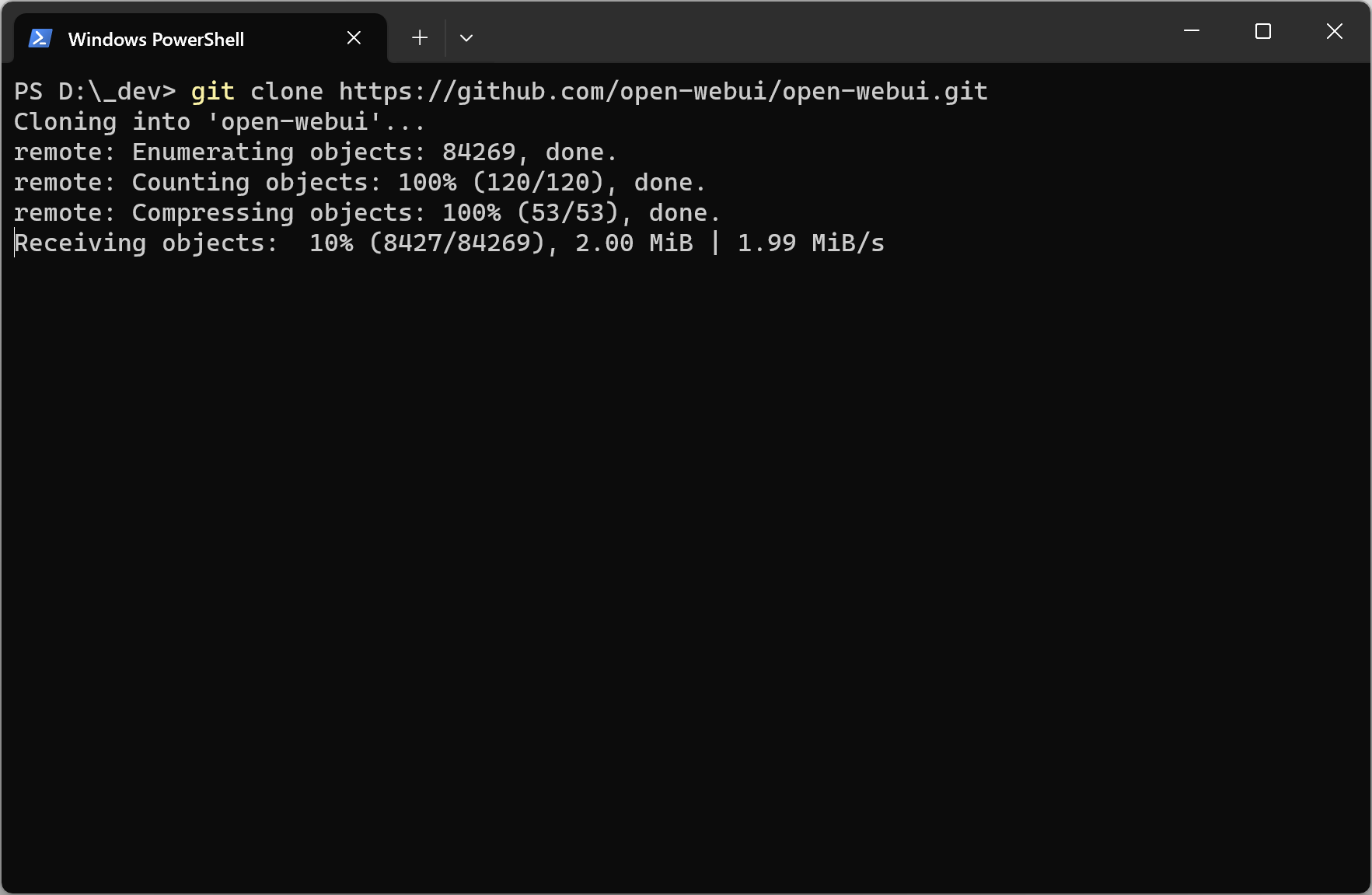

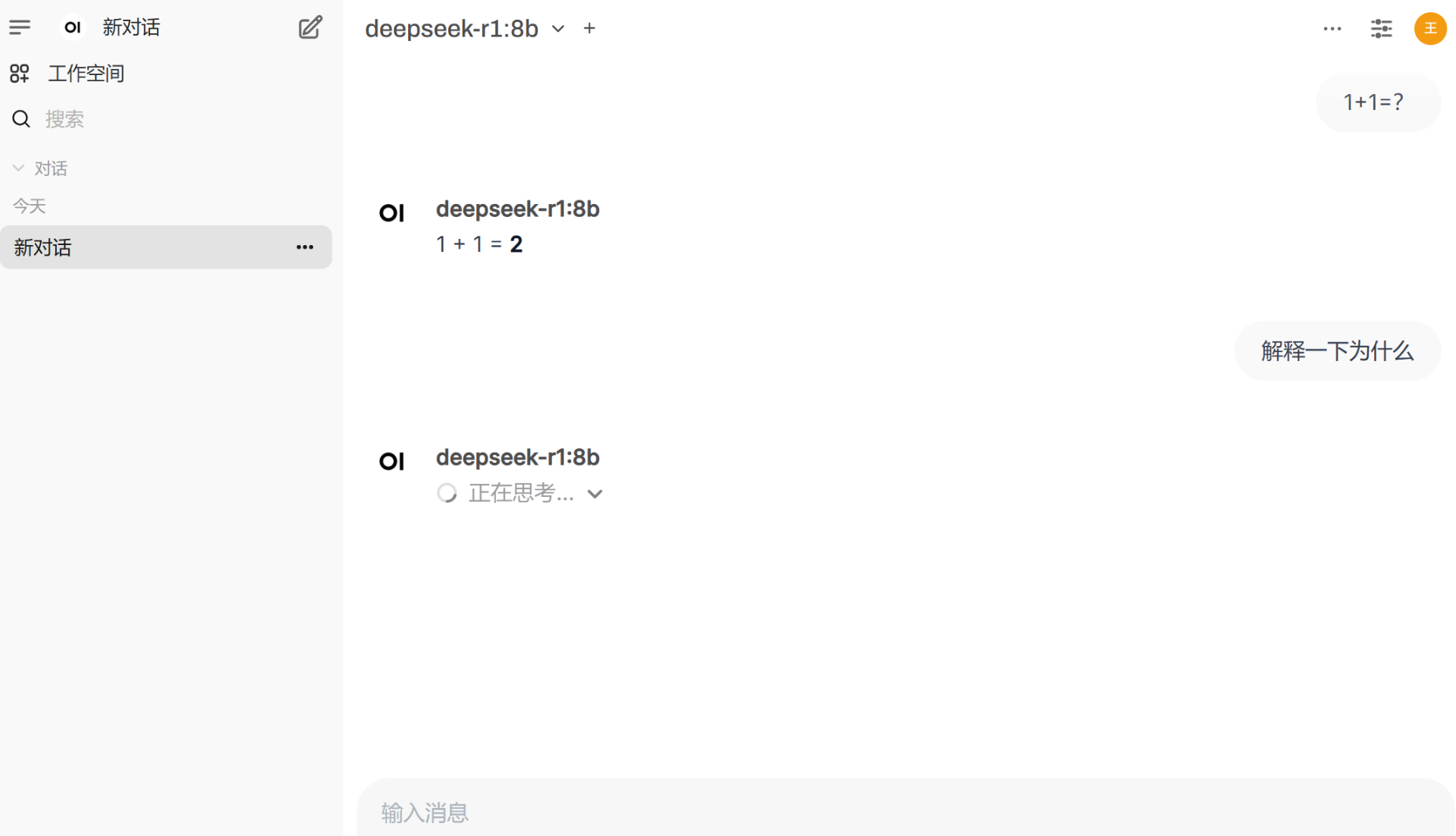

如果你觉得默认界面不够美观,可以考虑安装OpenWebUI来优化显示效果。

运行命令:git clone https://github.com/open-webui/open-webui.git

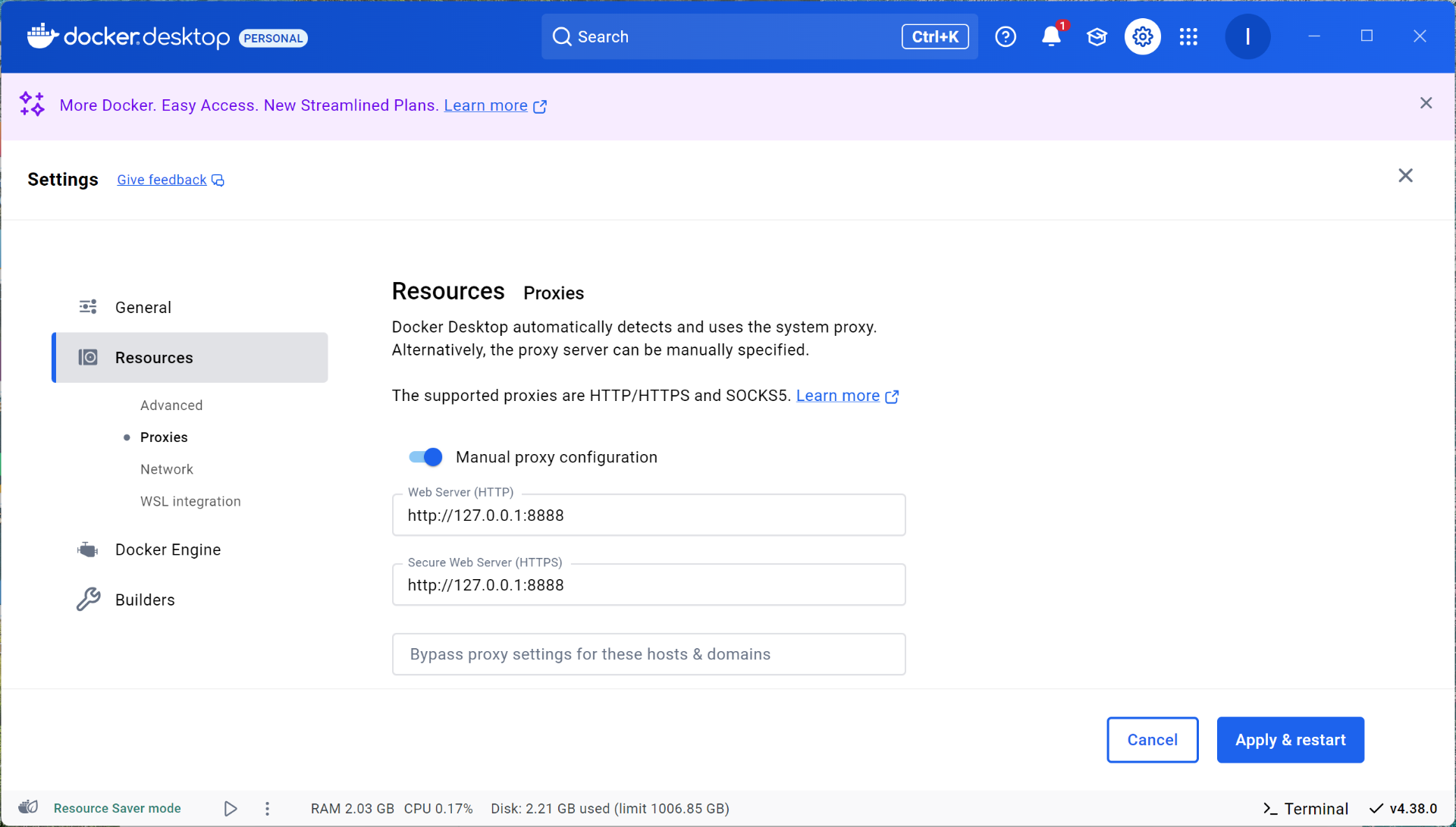

或者使用docker安装open-webui。

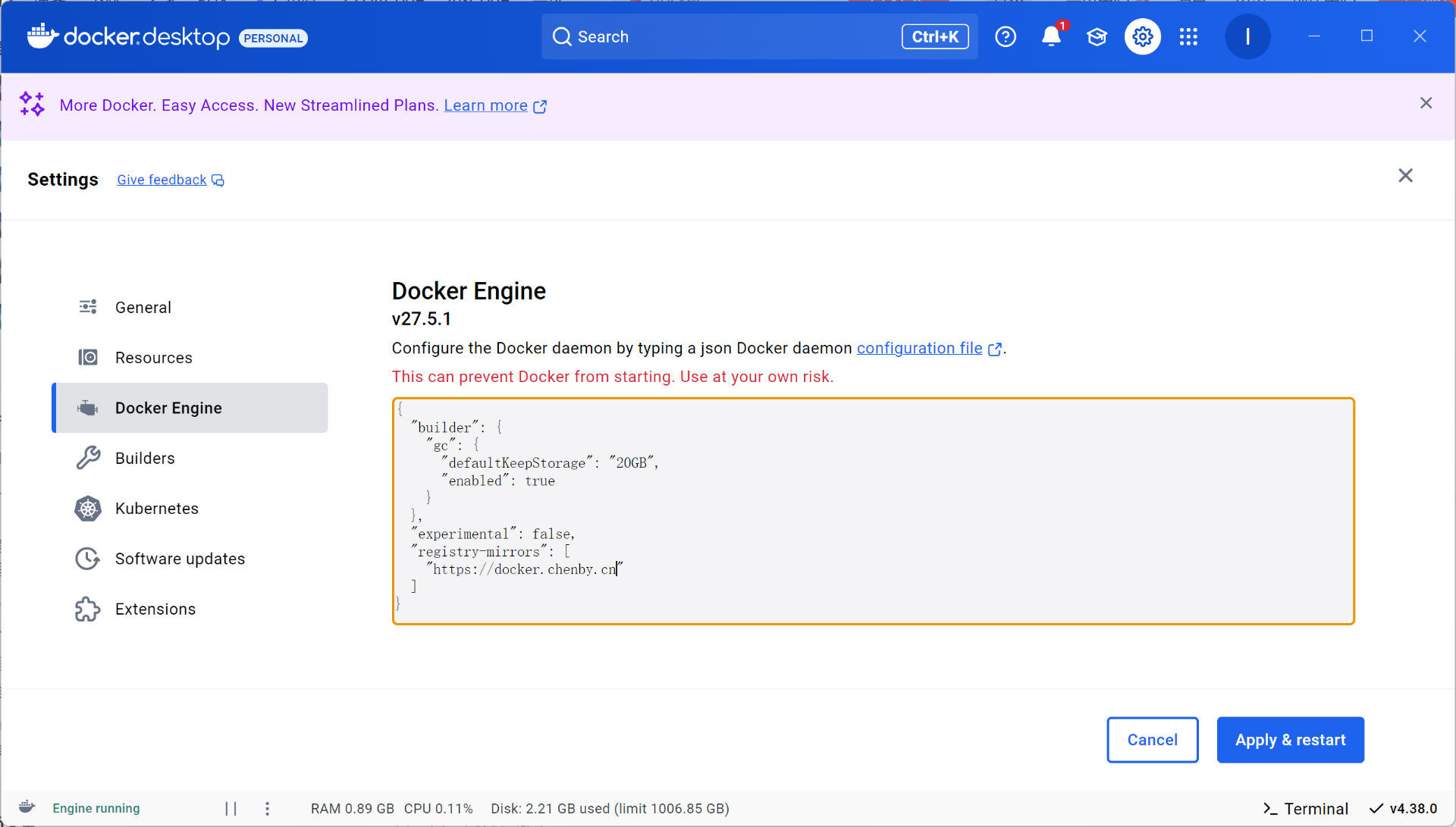

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"registry-mirrors": [

"https://docker.chenby.cn"

]

}输入以下命令拉取:

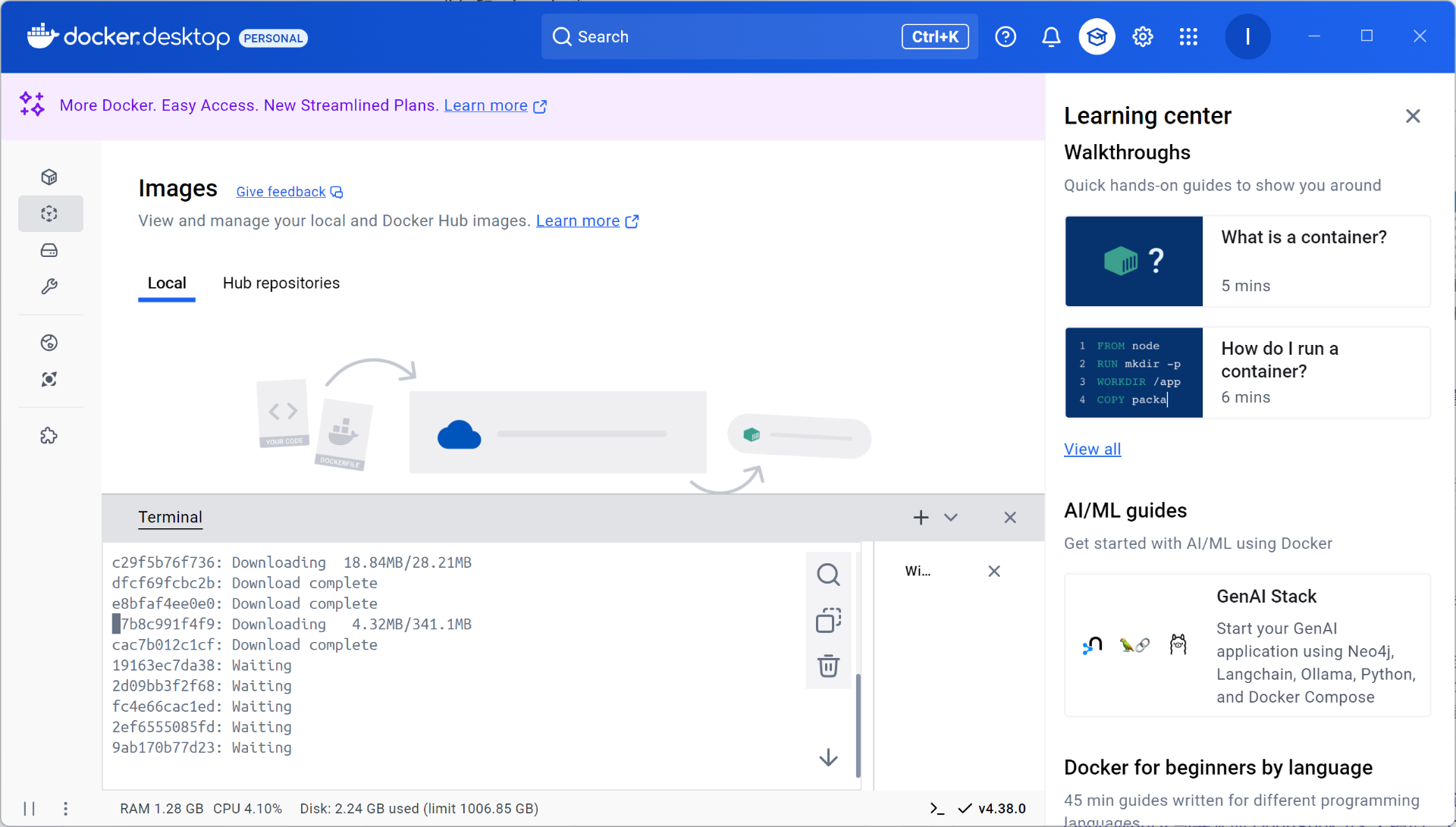

docker pull ghcr.io/open-webui/open-webui:main

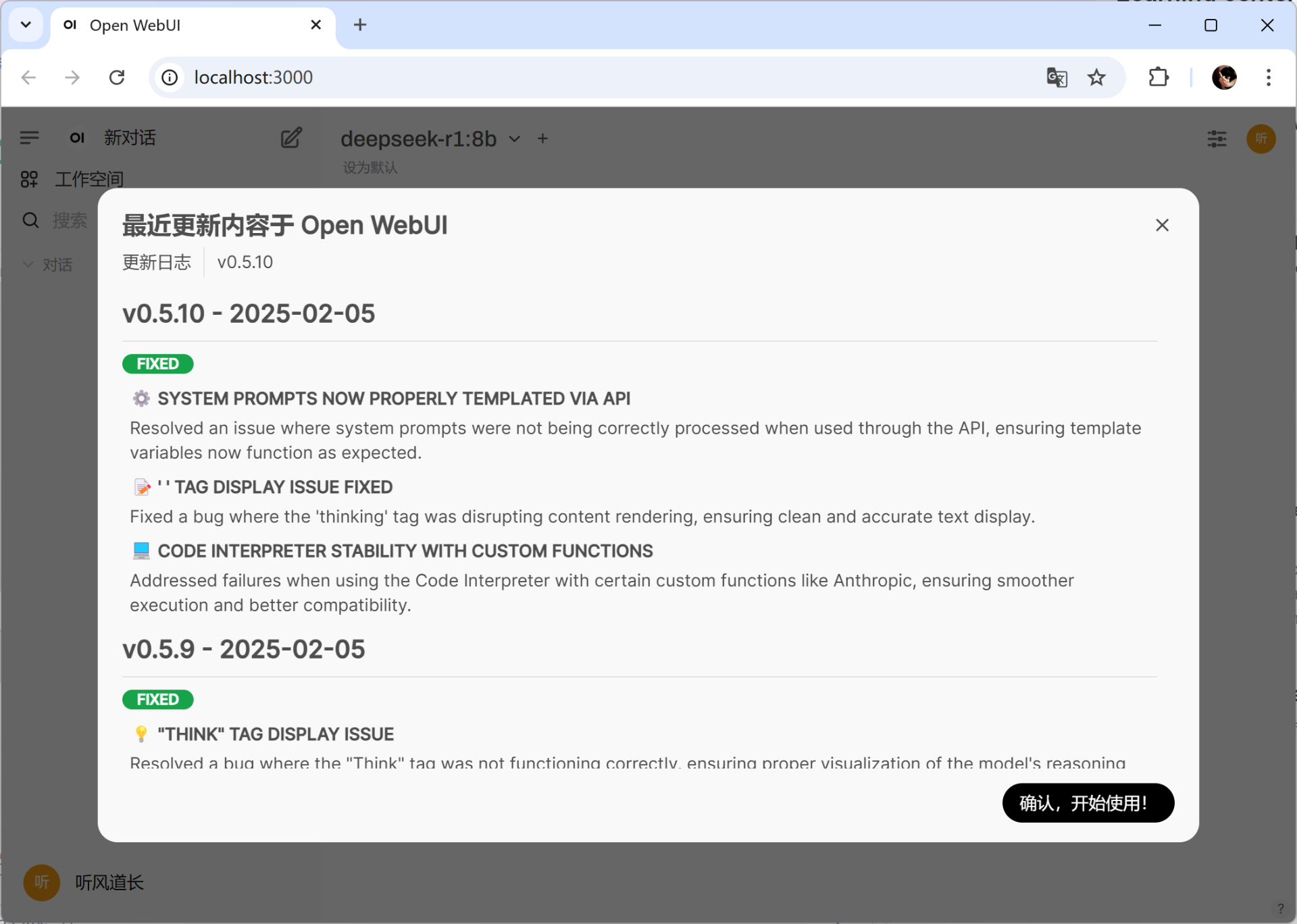

启动镜像后,根据镜像启动时设置的端口,打开访问地址,如:http://localhost:3000

由于模型运行在本地,你可以放心地让它处理各种数据,完全不用担心隐私问题。

到这里你认为就结束了吗?下面才是重点,接下来是我发现的 Deepseek自由版模型:

deepseek-r1-abliterated如果你部署了这个自由版模型,新世界的大门将向你敞开……